展示

Innovative Technologies

「ワールドワールドズ」(回転する地球)

会津大学 スペーシャル メディア グループ; Eyes, JAPAN; GClue

アバターの設定において、衣装、小道具を含んだ、場所との間でのシームレスな切り替えが出来る様になり、仮想シーンをより豊かに展開できます。

この「exertoy」又は、「exergame」は、アクティブなインタフェースで、全身の相互運動の 物理的インタフェースを表します。

このグループウェア機能は、動きを通して社会的な相互作用を進めます。このモーション キャプチャー(“mo-cap-style”)のインタフェースは、特別なマーカーや衣服を装着していません。直接操作で静止(ポインティング)、ダイナミックモード(回転や、変転)のいずれかで、制御と表示の間の連携を映像、音響、五感で提供します。音楽レンダラーの為の新型コントローラーです。

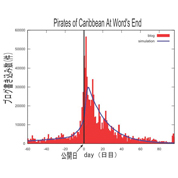

ヒット現象の数理モデル

鳥取大学 工学部 応用数理工学科 石井研究室

映画公開前後に投じられた1日ごとの広告・報道・宣伝費用、宣伝期間、知人から薦められる頻度やブログなど「口コミ」の定量的測定を「ヒット現象の数理モデル」として構築。実際に米映画の「アバター」「スパイダーマン3」や邦画「ALWAYS 三丁目の夕日」など25の映画で観客動員数の推移が事前予測と興行結果で一致し、かなりの精度で映画のヒット度を予測することに成功。また、ブログの書き込み数と観客動員数、売り上げも比例することを突き止めた。映画だけでなく、この数理モデルを使って2009年に開かれた世界砂像フェスティバルなど地域イベントの成功の可否、水木しげるロードの入場者数の予測、「食べるラー油」のヒット、2010年参議院選挙の当落、AKB選抜総選挙の順位なども予測。数理モデルを使うと、経験や勘に頼らず、企業が宣伝費用を投じる最適なタイミングを知ることができ、マーケティング戦略を緻密に練ることができる。限られた宣伝費用で最大限の効果を生み出すことが可能となる。世界200以上の報道機関で報道された。

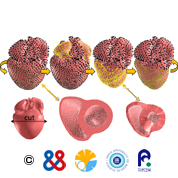

リアルタイム3次元心臓拍動シミュレータ

国立循環器病研究センター 研究所、東京大学大学院 情報理工学系研究科、滋賀医科大学 循環器内科、理化学研究所 基幹研究所

心臓は全身に血液を循環させるポンプの役割をする臓器です。心臓の構造はとても複雑で、その3次元的な動き(拍動)は簡単なイラストや動画で上手く説明できるものではありません。それを3次元の動画として分かりやすく表現するには、シミュレーションの技術が有用です。既存の力学モデルに基づく心臓シミュレータは、スーパーコンピュータによる大がかりな計算が必要であり、一般ユーザーがパソコンレベルで用いることはまず不可能でした。本システムではCG技法を応用して計算量の軽減を図り、心拍動を一般のノートパソコンでもリアルタイムに計算し、再現できるようにしました。現在、心臓モデルは約7000のパーツに分かれており、各パーツには予め標準的な拍動データが入っていますが、条件の変更によって心筋梗塞のような病気の心臓も比較的容易につくり出せます。さらに、拍動させたままの心臓を、ユーザーがマウスを操作して全方向から観察したり、マウスで切り取った心断面の動きを見たりすることも可能です。医師から患者さんへの説明用アプリケーションとしてだけでなく、医療スタッフ間のコミュニケーション支援、医学教育支援などへの応用も期待されます。

代替現実(Substitutional Reality: SR)システム

理化学研究所 脳科学総合研究センター 適応知性研究チーム

SRシステムは、過去に記録編集された映像を「いま目の前に起きている現実」として体験できる新しいプラットフォームです。SR状態をモチーフにしたSFに、「マトリックス」や「インセプション」がありますが、SR状態を作る事は、これまで技術的に困難でした。SRシステムは、現実から認知的なつなぎ目なしに過去の映像を与えることにより、過去と現実の境界を無くし、全てを目の前で起きていることのように経験させることに成功しました。このSRシステムは、新しい体験プラットフォームとしてさまざまな可能性を秘めています。これまでの映像表現は、見る、聞くというレベルでとどまっており、テレビや映画を見ても、それを自分自身が現実に経験したと感じることはほとんどありません。しかし、SRシステムを通じた視聴体験が与えるインパクトは、これまでのコンテンツ視聴と比較して明らかな差があります。つまり、SRシステムには、これからのコンテンツ体験のありかたを変える可能性があり、従来のVRやARの「仮想を現実に近づける」技術とは逆に、過去を現在に浸入させ、体験者の経験する主観的な「現実」そのものを操作することができる技術なのです。

高速・高精度な顔画像処理に基づくものまねアバターシステム

慶應義塾大学 理工学部 システムデザイン工学科 満倉研究室

慶應義塾大学理工学部の満倉靖恵准教授らの研究グループは、USBカメラ1台を利用したリアルタイム頭部姿勢推定・表情認識手法を提案しました。また、これらの技術を用いた応用として、顔の向きや表情をリアルタイムで操作可能なアバターシステムを開発しました。

映画やゲームなどのCGアニメーション製作において、キャラクターのモーション生成は特殊な機材を必要とすることが問題となっています。今回の研究では、一般的なPCとUSBカメラを用いて人間の顔の向きや表情の変化を高速・高精度に計測する手法を開発しており、実用性に富んだシステムへの応用が可能となりました。このため、リアルタイムにキャラクターを操作することが可能となっており、特殊な機材を必要とせず、誰でも簡単にキャラクターを操作できる簡易なアバターシステムの開発が可能となりました。

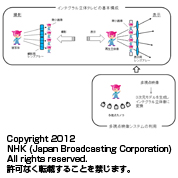

インテグラル立体テレビ

日本放送協会

インテグラル立テレビは、立体写真の技術として発明されたインテグラルフォトグラフィの原理に基づいています。被写体から発せられる光線の方向と強度を取得するために、撮影時に多数の微小レンズを並べたレンズアレーを通して撮影します。表示時は、撮影時と同様のレンズアレーを用い、被写体から発せられる光線と等価な光線を再現することで立体像を生成します。

今回は、直径2.64mmの微小レンズを水平182個×垂直140個配列したレンズアレーと、水平3840画素×垂直2160画素の液晶ディスプレイを用いた表示装置を展示します。文字スーパーやCGなどを実写の立体像に重畳して表示することが可能であり、光学系の収差に伴う色ずれを抑圧する処理をかけ、より見やすい立体像になっています。また、複数のカメラを使って撮影した多視点映像から、被写体の3次元モデルを生成し、その3次元モデルから生成した立体像についても展示します。

今後、より高品質な立体像を生成するための撮影、表示技術の開発、立体像生成技術の多様化などの研究を進めていきます。

MM-Space: 次世代ビデオ会議のための会話場再構成システム

NTTコミュニケーション科学基礎研究所

MM-Spaceは、次世代ビデオ会議システムへの応用を念頭とし、遠隔地にいる複数の人の会話を、あたかもその場にいるかのように再現することを目指したシステムです。最大の特徴は、会話者の顔画像をスクリーンに投影しつつ、そのスクリーンを人の頭の動きにあわせて動かす、つまり、人の頭部運動をスクリーンの物理的な運動として補強して提示するという新しい表現方法・表示デバイスを提案した点にあります。本システムでは、会話者の配置に合わせて、別地点に複数のプロジェクタ、透過型スクリーンが配置され、各スクリーンに等身大の人物像が投影されます。スクリーンにはアクチュエータが接続され、フェイストラッキングにより得られた人物の頭部姿勢と同期して、スクリーンの姿勢が動的に制御されます。それにより視線や頷きといった会話における重要な非言語行動や、「誰が誰に向かって話しているか」などインタラクションの状態が、よりわかりやすく見るものに伝達されます。また、透明スクリーンに人物の背景を抜いた人物画像を投影することで、遠隔の人の姿がその場の風景にとけ込んだように表示され、高い臨場感・存在感を作り出すことが出来ます。

新感覚タッチパネル(リアル触感の実現)

京セラ株式会社

現在、様々な機器が「振動」により「触ったことを知らせる」機能を搭載しています。しかし平らで硬いパネル上であたかも本当のキーなどに触った感覚を出すことはまだ実現されていませんでした。今回「指神経への刺激で起こる錯覚を用いて触感を与える」という触覚伝達技術を、当社の要素技術であるタッチパネルと圧電素子にて実現できるようにし、今までにないリアルな触感を呈示することができました。元々、単に振動させるだけでは、人が触れた時に感じる「圧覚」と「触覚」を生み出せず、リアルな触感は実現できません。そこで、圧電素子に振動と圧力検知の両方を行なわせ、さらに一定の振幅量、周波数、タイミングを1つの制御装置に集約、生成することで、実現しました。また、この方式により、本物のキーの触感だけでなく、「硬い、柔らかい、ゼリーの様な」という多様な触感も再現できるようになりました。今後この技術は、タッチパネル搭載機器に広く利用されていくと考えられますが、今回実現したことは「触覚呈示」の最初の入り口に過ぎず、これをトリガーに今後の研究開発により、ユーザインターフェースに必要なあらゆる触感を創造していきたいと考えます。

透明プリウス

慶應義塾大学大学院 メディアデザイン研究科 稲見研究室

光学迷彩の技術をプリウスに搭載することで、ドライバーから後部座席があたかも透明になったように車両後方をみることができるシステムです。

これにより、通常では死角となって見えない部分にある障害物などが容易に確認できるといった様に、車両後方の視認性向上を実現しています。

本システムは車両周辺環境の安全性を向上するという課題に対して、周辺映像を車内の小さな画面に表示するのではなく、ドライバーが周囲を見渡すことにより、周辺環境を、実際に存在する位置に、実寸大で視認できるという点に高い独創性があります。本システムにより、ドライバーの死角を大幅に減らし、ドライバーと車両の身体感覚の一体化をより促進することで、運転時の安全性のみならず安心感をも向上させることが期待されます。

また本研究で用いる再帰性投影技術は我々の研究グループが最初に提唱した独自の研究であり、国内・国外で当該技術に関し権利化を行なっているため、技術的独創性も高いものとなっています。

Agni’s Philosophy

株式会社スクウェア・エニックス

近年のリアルタイムCG映像技術の発展とグラフィックスボードの性能向上は目覚ましく、その品質はプリレンダーCG映像の品質に肉薄する水準に高まりました。

本作品「Agni’s Philosophy - FINAL FANTASY REALTIME TECH DEMO」は、まず最初にCG映像部門により高品質プリレンダーCG映像作品が制作され、そのデータを元にスクウェア・エニックスが開発中のゲーム開発環境「Luminous Studio」を用いてリアルタイムCG映像に変換しました。リアルタイムCG映像が持つ可能性を切り開く作品となっています。

世界初、AR(拡張現実)情報をフロントガラスの前方に映し出すヘッドアップディスプレイ「AR HUDユニット」

パイオニア株式会社

AR情報を映し出す「世界初」の「AR HUDユニット」は、車のサンバイザーの設置場所に装着し、ドライバーの目から約3m先に37型(90×30cm)相当の映像を現実の風景に重ねて映し出します。ルートや曲がるべき交差点など、誘導に必要な情報を目の前の道路に重ねて表示できるため、直感的な誘導が可能となります。また、光源に高輝度・高コントラストを特徴とするレーザーを使用することで視認性が向上し、運転に必要な様々な情報を素早く確認できるほか、ダッシュボードに取り付けられたカーナビ画面を確認する場合と比べて、視線移動と遠近の焦点合わせの時間を大幅に低減することが可能となり、より安心、快適なドライブを楽しむことができます。

メディアブロックチェア

チームラボ株式会社

メディアブロックチェアは、凸の面が3面、凹の面が3面からなるキューブ型のブロックであり、照明器具であり、イスです。ブロックは、単体としては、イス。ブロックは、ジョイントした時に、凸の面から、凹の面へ情報を伝え、凹の面のブロックの光の色を変えます。自由にジョイントしていくことで、空間の形や、空間の色を変化させます。空間の機能を変えるために空間を変化させる行為、その空間を変化させる行為そのものも、楽しんでもらうという『New Value in Behavior』のコンセプトが使われています。

(チームラボ, 2012, インタラクティブチェア)

2次元通信によるヒューマンインターフェース

東京大学 大学院情報理工学系研究科 システム情報学専攻 篠田研究室

2次元通信とは薄いシート状媒体に電磁波を閉じ込め、そこに近接するカプラに選択的に信号と電力を伝送する技術です。伝送シートに近接結合する特殊カプラを備えた端末に対し個別配線なく電力/信号が伝送でき、シートに近接する一般物体が強い電磁場にさらされることはありません。また伝送シートの構造は単純であり、安価な材料で製造して机の表面などに組み込むことができます。このようなワイヤレスかつ選択的な電力の供給と、外部空間と干渉しない通信が可能になることによって、日常生活で触れる様々な物体にヒューマンインターフェースの機能を付与することが可能となります。具体的には電子ペーパを複数枚利用しながら効率よく作業を進められるデスクトップや、日常の生活用品にもリアルタイムでの情報表示や人間とのインタラクション機能を埋め込んだ人間支援システムを展示します。

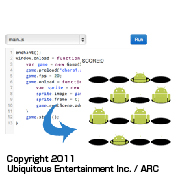

enchant.js

株式会社ユビキタスエンターテインメント

ノートPCやタブレット、スマートフォンなど、enchant.jsが対応するハードウェアを展示しデモを行います。また、ブロック型プログラミング環境「前田ブロック」によるプログラミングデモも行う予定です。他にロサンゼルスで開催された子ども向けenchant.jsワークショップの模様のパネルの掲出などを予定しています。

宙海月-触手ロボット

東京大学大学院 情報学環 河口研究室

宙海月は、CGアーティストを最先端なロボット技術で表現されたものです。我々は、生体原理に基づいて,クラゲロボットの触手を試作しました。ワイヤ、バネと金属プレートで構成された宙海月ロボットの触手は、その三本のワイヤを引っ張ると、触手を実際な生物のように動かせます。生物の触手のメカニズムと近くて、表現力が高いです。さらに、宙海月ロボットは、接近センサーも持って、人間とのインタラクションもできます。人のいない時の寝ている状態から、人が接近すると目を覚ますように動き始めます。我々の提案した手法は、インタラクティブアート作品に対するビジターの満足感を高める効果を期待できます

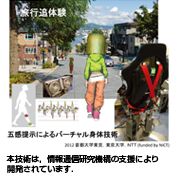

追体験のためのバーチャル身体技術

首都大学東京大学院 システムデザイン研究科 池井研究室、東京大学大学院 情報学環 広田研究室、日本電信電話株式会社 コミュニケーション科学基礎研究所

バーチャル身体技術とは、他者の行動を記録して五感に再生提示することにより、疑似能動的に追体験を楽しむための技術です。これは、1)多感覚情報の同時提示、2)多感覚情報の相互作用、3)能動的運動感覚誘起、などに関する技術から構成されています。多感覚情報とは、従来から利用されている視覚、聴覚に加えて、嗅覚、前庭感覚、力触覚、風覚などの感覚を含む感覚群に関する情報です。これらを同時に提示すると、各情報に対する受容の特性は単独の場合と異なったものとなるので、そうした相互作用を考慮した提示を行います。1)、2)は体験者の周囲の環境を臨場感高く再現するための技術ですが、これに加えて、3)では体験者自身の能動的な運動感覚に関する表現を行います。これは、記録された他者の体験情報を用いながらも、あたかも自分の身体が能動的な意思に従う中で体験したかのような臨場感が得られることを目指す技術です。体験者の身体をバーチャル化し、例えば、他人の歩行などの能動的な身体運動状態を疑似能動的に追体験します。これにより、さまざまな場所に行って、歩いてみた時の状況を、臨場感高く楽しみながら追体験することが可能となります。

拡張満腹感

東京大学 大学院 情報理工学系研究科 知能機械情報学専攻 廣瀬・谷川研究室

「拡張満腹感」は、拡張現実感によって周囲のものの大きさは保ったまま食品の見た目のサイズだけを操作することで、食品を食べたときに得られる満腹感を操作し、満腹感は一定のまま食事量を変えてしまうことが可能なシステムです。近年、食事から得られる満腹感は、食事そのものの量だけでなく、盛りつけや見た目、一緒に食べる人数など、食事の際の周辺状況に大きく影響を受けることがわかってきました。こうした知見から、食事そのものを変えなくとも、満腹感に寄与する要素に対する知覚を変化させることで、食事摂取量が操作可能になると考えました。拡張満腹感システムでは、食品の見た目の量に着目し、リアルタイムに視覚的な食事ボリュームを変化させてフィードバックします。このとき、デフォーメーションアルゴリズムを利用して食品を握る手を適切に変形することで、手のサイズは一定のまま、対象となる食品のみを拡大・縮小することが可能になっています。実験を通してこのシステムがユーザの食品摂取量に影響を与えるかを評価したところ、得られる満腹感は一定のまま食品摂取量を増減両方向に約10%程度変化させる効果があるという結果が得られています。

DIVE into World Heritage 3D

パナソニック株式会社

「DIVE into World Heritage 3D」とは、30°という開角度で扇型に設置した5台の当社一体型二眼式3Dカメラ(AG-3DA1)をタイムコード同期させて視野角150°/計5ソース(L/R 10ソース)の3D映像として世界遺産をマルチ収録し、上映するシステムです。上映に当たっては撮影時に設定した開角度と同じ角度に配置した5台の当社の大型3Dディスプレイに5ソースを同期して再生します。ディスプレイの額縁幅も考慮し、それぞれの3D映像が同じ立体感、自然で連続的な映像に見える立体設計を行っています。それぞれのカメラはL面R面をフルHDで収録、計10ソースのタイムコード同期をとって撮影しています。また、音声も5.1chサラウンドサウンドと組み合わせて臨場感のある映像体験空間を作り出します。

従来TVと互換性のある新3D放送方式「Advanced Stereo 3D」

株式会社NHKメディアテクノロジー

NHKメディアテクノロジーとNECは、従来の2D受信機と互換性のある3D放送方式「Advanced Stereo 3D(AS3D)」を提案しています。これまでの3D放送は、左右の映像2画面分を横方向に1画面分に縮めて放送しており、この方式は解像度が半分になるだけでなく、従来の3D非対応の2D受信機で受信すると、左右映像が縦長の2画面表示となって視聴できないという大きな問題がありました。本方式によれば、従来の受信機ではフルスペックハイビジョン映像を受信でき、本方式に対応した3D受信機ではフルスペック3Dハイビジョン映像を楽しめます。本方式では、これまで圧縮装置の処理能力の問題で使われなかった圧縮モード(フィールドピクチャー構造)を画像に適応して制御する新たな方法を駆使することで、従来の画質を維持したまま圧縮率を高めることができました。これにより、BSデジタル放送に適用した場合には、左目の映像はMPEG2規格互換性を保ったまま従来の65%程度に圧縮し、右目の映像はワンセグ放送でも使われているH.264(AVC)方式で圧縮することで残りの35%の帯域に圧縮して多重することができます。

QUMARION(QUMA技術:入力装置ならびに制御技術)

株式会社セルシス/ソフトイーサ株式会社/株式会社ビビアン

QUMA技術は、入力装置およびその制御機構に関する技術です。QUMARIONは、この技術を元にイラスト、マンガ、キャラクターアニメーション等の作成をサポートするために開発されました。関節部分には32個のセンサーが設置されており、QUMARIONを操作することにより、ソフトウェア上の3Dキャラクターを動かすことができます。これにより、従来のマウス操作では難しかった3Dキャラクターの操作を直感的に行うことができるようになります。

QUMARIONは現在、次のソフトウェアに対応しています。イラスト制作ソフトウェア「CLIP STUDIO PAINT PRO」、モーション作成ソフトウェア「CLIP STUDIO ACTION」、キャラクター編集ソフトウェア「CLIP STUDIO COORDINATE」、Autodesk® Maya/Max用プラグイン。また、QUMARION SDKにより、様々なソフトウェアでQUMARIONを動作させることが可能です。展示においては、QUMARIONとソフトウェア(イラスト制作、モーション制作)のデモを実施しております。

Pinch: 複数の画面をつまんで繋げるユーザー・インターフェース

東京工科大学大学院 バイオ・情報メディア研究科 メディア学専攻 コム・メディア・デザイン研究室

「つまむ」動作によって、複数のタッチパネル画面を備えたモバイルデバイスで動作しているコンテンツの表示を連携させるインターフェース:Pinchを紹介します。タッチパネルを備えるスマートフォンやタブレットPCなどを対象として、隣接させた二つの画面のそれぞれに親指と人差し指を置き、つまみ合わせるような動作をすることで画面が繋がり表示領域が拡大するなどのインタラクションを実現するものです。デバイスをアプリ実行中に追加したり取り除いたりすることが可能です。また、画面は縦方向でも横方向でも好きに配置できますし、ずれた位置でつなぎ合わせることも可能です。このインターフェースを利用して複数のアプリを設計しました。このインターフェースが、多様なコンテンツの新しい表現やインタラクションを生み出すことができる潜在力を示したいと思っています。複数のスマートフォンで遊ぶためには、何名かで持ち寄ることが必要でしょう。そのため、ネットワークを介さない直接的なコミュニケーションを生むきっかけになるようなアプリの土台となることも期待しています。

Hand-rewriting

東京大学 大学院 情報理工学系研究科/学際情報学府 苗村研究室(橋田朋子、西村光平、苗村健)

Hand-rewritingは紙とペンによる手描きスケッチを対象として、紙面上で、その手描きスケッチを自動的に消去したり、連動した情報を印刷のような自然な発色で瞬時に印字することができるPaper Computing技術です。紙とペンによる手描きは多くの人が慣れ親しんだ行為であり、最近ではこれを情報世界とうまく繋ぐ技術が望まれています。既に、デジタルペンを使って手描きスケッチを電子化することや、ペンタブレットによる手描きスケッチを認識してディスプレイ内で自動的な編集を可能とすること、は実現されていますが、紙の上の手描きスケッチを紙の上で自動的に編集加工することは難しい課題として残されていました。Hand-rewritingでは、サーモクロミックぺンで描いた手描きスケッチに対し、紙面の裏側からレーザ光を照射して黒膜で熱変換することで、0.024mm間隔で紙面の手描きスケッチの局所的な消去を可能とします。一方、紙にはフォトクロミック材料をあらかじめ塗布し、2次元の紫外光パターンを投影することで、1024×768の解像度の所望の発色パターンを紙面に動的に表示することを可能とします。

国際パートナープログラム

「フチュール アン セーヌ」 デジタルワールドフェスティバル 2013年6月13~23日 パリ地区

フチュール アン セーヌ / キャップ・デジタル

フチュール アン セーヌは、革新的デジタル技術を業界関係者や一般の方に披露する祭典です。2013年は4日にわたり、広さ4,000㎡を誇る有名な文化施設 "CENTQUATRE" で開催されます。

韓国スマートコンテンツショーケース

韓国コンテンツ振興院

韓国アプリコンテンツ体験コーナー

・Reccod Video Camera Pro(Ahiku Corporation):スマート生放送アプリ

・PicPlay Pro(JellyBus):写真・イメージ編集アプリ

・My Wonderful Days, BooksWing(haha Interactive):ライフスタイル便利ツールアプリ

・Somnote, Somtodo(Wizard Works):クラウドベースの便利ツールアプリ

・MoglueBuilder, MoglueViewer(Moglue):インタラクティブ電子ブックソフト

・Paladog!(FazeCat):ディフェンスゲームアプリ

・Unforget(Waterbear Soft):語学教育アプリ

シーグラフアジア 2012

SIGGRAPH ASIA 2012

SIGGRPAH Asia は世界最大規模のCGとインタラクティブ技術を中心としたデジタルメディア、デジタルコンテンツに関する国際的な祭典です。立体視関連の次世代映像技術や最新のバーチャルリアリティ技術など、毎年、興味深い展示が多く、会場では活発な情報交換が行われ、CG・アニメ制作業界のプロ、制作会社やアニメーションスタジオなどの企業との出会いの場を提供します。世界各国から新たなパートナー、情報収集、最適な付加価値を求めてシンガポールに集結します。是非この機会に、情報収集や販路の拡大のためにシーグラフアジア2012をご活用ください。

SIGGRAPH Asia 2012 http://www.siggraph.org/asia2012/。

2012年11月28日(水)~12月1日(土)会場: Singapore Expo(シンガポール)

問い合わせ先: シーグラフアジア日本事務局(ケルンメッセ株式会社)TEL: 03-5793-7770 FAX: 03-5793-7771 Email:kmjpn@koelnmesse.jp

国際3D協会 日本部会

国際3D協会 ルミエール・ジャパン・アワード2012 受賞作品3D連続上映

国際3D協会 日本部会

国際3D協会(International 3D Society:I3DS)は、2009年に米国で設立され、現在、3Dコンテンツに関連する400以上の会社・団体が加盟しています。教育活動としての3D Universityや、表彰活動としての3D Creative Arts Awardsなどを積極的に展開しています。I3DS日本部会(I3DS-J)は、韓国部会、中国部会と共にI3DS傘下のアジア部会に属しており、わが国における3Dコンテンツの芸術・技術の発展・普及を目的として、2011年に設立されました。米国本部のハリウッドとのチャンネルを活かして、日本国内の会員企業が連携し、教育・表彰・研究活動を推進しています。I3DS-Jでは、良質な3Dコンテンツの拡大と品質向上を図るため、国際3D協会ルミエール・ジャパン・アワードを開催しています。本展示では、その受賞作品のダイジェスト版を、3Dで連続上映いたします。

ASIAGRAPH CG アートギャラリー

ASIAGRAPH 2012 in Tokyo CGアートギャラリー

ASIAGRAPH CGアートギャラリー

ASIAGRAPHでは、優秀なCG作家と作品が国を越えて交流することで、新たな創造と産業がアジアから生まれることを願い、優れた作品の発表展示の場として過去8年間、国内外の会場でCGアートギャラリーを開催して参りました。今年度も日本、中国、韓国、台湾、香港、シンガポール、タイ、マレーシア、ミャンマー、ベトナム、フィリピン、インドネシア、インド、スリランカなど、多くの国と地域から作品が寄せられ、招待展示、公募展示両部門とも多様で充実した作品群を展示します。公募展示部門は、広くアジア地域から作品公募を行うことで、より自由なCG表現を受け入れる作品展示を目指し、2007年から作品募集を開始し、本年度で第6回を数えます。今年度もアジア14の国と地域から600点を超える応募がありました。中でも動画(アニメーション)作品公募第二部門は、アジア10カ国14人の審査委員による国際審査が行われ、入選作品を決定いたします。アジア各国の固有の価値観とニーズを反映し、尚かつ公平な審査によって選定された入選作品は、この地域の映像表現の水準を示す「指標」と呼ぶに相応しいでしょう。

IVRC

第20回国際学生対抗バーチャルリアリティコンテスト(IVRC2012) 決勝大会

日本バーチャルリアリティ学会 IVRC実行委員会

国際学生対抗バーチャルリアリティコンテスト(IVRC)は、バーチャルリアリティやロボットといった先端技術を用いたインタラクティブな作品のコンテストです。1993年から開催され、バーチャルリアリティの枠にとらわれない独創的で親しみの持てる作品を数多く生み出してきました。

本年も5月の書類審査から始まり、日本全国から実に89件の応募作品が集まりました。その後プレゼン審査、予選大会での一般公開展示を行い、この長い戦いを勝ち抜いた8作品と、ヨーロッパ最大のVR祭典LavalVirtual学生作品の中から選出された1作品をシードとして加え、計9作品がDCEXPOと併催の決勝大会(10/25-27@未来館)で優勝を賭けて本年最後の戦いを繰り広げます。感動のフィナーレを迎える表彰式では、総合優勝(賞金30万円)をはじめとして、各協賛企業賞、明和電機社長賞、ラヴァルバーチャル賞等の栄誉と豪華副賞が与えられます。

またIVRC第20回の節目として創設された「IVRC2012ユース部門」の展示会も開催!

DCEXPO最終日にはIVRC決勝大会表彰式も開催!お見逃しなく!

参加プログラム

3D映像とクロスモーダルを融合した新感覚VRワールド

株式会社ソリッドレイ研究所

本技術は、3D映像と振動伝達による錯覚を利用して、クロスモーダルな感覚情報の提示を促すものです。目の前に3DCGキャラクターが等身大で現れ、被験者が持つコップに液体を注いでくれます。被験者は振動子による錯覚で、あたかも本物の液体がジョボジョボと注がれているように感じてしまいます。このようなVR空間で視覚的・触覚的錯覚を生み出すことにより、こちらが提示していない感覚(冷たい、重いなど)が被験者の中に生じることを目指します。

※注 本記述内における「振動子」とは、KMD・舘研究室の開発によるTECHTILE toolkitを意味しています。

nagarami ~SmartTV時代の情報浴インテリア~

株式会社AOI Pro.

nagaramiにおける技術的ポイントは、映像・フィード・音楽に「感性タグ」を付与しそれによって分類された映像・テキスト・音楽がサーバでリアルタイムに合成された映像コンテンツを配信します。

「感性タグ」は、これまでのニュースサイト等で用いられているタグとは異なり、より人々の気持ちや状況を反映させたタグです。

そして感性タグの精製と付与は"IJ(Information Jockey)"と呼ばれる人々の手によって行われるため、配信されるコンテンツはよりTPOに適したものになっています。今後普及するHTML5を搭載した機器(SmartTV、STB、PC、スマートフォン)での視聴に適した配信方法にすることで、デバイスに依存しない配信が可能です。

Gnzo - Catch more videos. : インターネット動画を複数同時再生

株式会社 Gnzo

昨今のWebデザインでは、よりマルチメディア化がすすみ、複数の画像コンテンツを利用することも珍しくありませんが、複数の動画コンテンツを利用したWebデザインはなかなか見かけることはありません。これは、ネットワークのオーバーヘッドが大きくなりすぎてしまう、デコード処理を同時実行することができない、などの問題によるものです。Gnzo社では、サーバーサイドに「fabric video」というトランスコーディング技術を組み込むことで、クライアントにHTTP, H.264, MP4といった通常のブラウザ(Flash/Silverlight等のプラグインを含む)のみがあれば、複数の映像コンテンツを再生できるようにしています。これらの技術は、Gnzo自社サービス(http://gnzo.com/) 上で、HTML5 と iPhoneアプリとして提供されています。また、Web上から簡単にトランスコーディング技術を利用できるように、Web API ライセンスサービスを提供中です。なお、今後の展望として、リアルタイムストリーミングのデモと、Web 3D UI をGnzo ラボとして展開しております。

ドレモサンディー

株式会社クエイザーテクノロジー

doremo3Dビューアーは曲面反射の原理にもとずいて、右と左の目に擬似視差のある別々の映像を送ります。 ですから完全裸眼です。 しかしparalax barrier方式 と違って映像にツギハギができません。 3次元に変換するソフト、及びそれにかかる時間が不要で2次元映像をリアルタイムで3次元化します。 2平面画像方式の立体視では、多くの一眼領域が残ります。一眼領域には視差はありませんから左右の目は別別の平面映像を見ています。 この領域に焦点を合わせようとしても輻湊は永久に安定しません。右と左の一眼領域が交互に見えるためキラキラと輝いたような平面的な映像になり映像が不自然にくっきりはっきりしてみえます。doremo3Dビューアーでは一眼領域がなく、ごく自然な立体視ができます。

ブラウザ上のコンテンツ(地図・気象データ等)の3D化技術

株式会社 匠技研

HTML5とWebGLによる3D地図表現。更にその地図上に天気のデータ(=株式会社ライフビジネスウェザー殿提供)をオーバーレイして、特定の時間・場所での天気を3D表現にて、見やすく高速に表示をする。ブラウザ上で画像データを3D表現するのは非常に難しいことです。が、弊社では①地図という大量のポリゴン情報を扱うデータと②気象データというリアルタイム性の必要なデータを同時に搭載し、しかも非常に高速に処理できることが特徴となっております。気象データはこれまで2Dの地図上で表すことがほとんどでしたが、これに高さを加えることで気象データを非常に分かり易く表現することができ、プロフェッショナルの判断材料にすることも出来るようになりました。気象データの新しい表現方法として大変に有効なものになりうると考えております。気象のみならず、その他のデータも3D地図上で表現する事も企画中です。(内容未定)

多元的デジタルアーカイブズ・シリーズ

首都大学東京 渡邉英徳研究室

「多元的デジタルアーカイブズ」とは、既存のデジタルアーカイブ群とユーザコミュニティをマッシュアップし、VR-AR(仮想現実-拡張現実)インターフェイス上に表示するものです。この「多元的デジタルアーカイブズ」のユーザは、複数のデジタルアーカイブを横断的に閲覧しながら、コンテンツ相互の時空間的なつながりや身近な場所との関わりを把握し、アーカイブ群の内容について、より深く知ることができます。今回の展示では、近未来に実現するであろう航空機技術を、仮想航路に沿ってクルージングしながらプレゼンテーションする「START on AIR!」、そして「ヒロシマ・アーカイブ」「東日本大震災アーカイブ」などの戦災・災害に関する多元的デジタルアーカイブズ・シリーズを展示します。

VRとAR技術による新しい都市空間の演出

森ビル株式会社

森ビルが環状2号線Ⅲ街区計画をモデルに研究を進める都市空間の演出についてご紹介します。コア技術は、VR技術とAR技術の2部構成となっています。VR技術ブースでは、フルハイビジョンの高精細テクスチャーによって作られた仮想都市空間内を自由に動き、体験することができます。現実の都市開発を行うディベロッパーが仮想都市空間を構築するため、情報の信頼性が高く、今後仮想空間内での商業施設の展開や、広告宣伝や販促活動等のビジネスモデルの展開を可能にします。AR技術ブースでは、AR技術とモーション認識技術を活かしたAR都市ミュージアムを体験できます。実写映像に映るAR都市模型が体験者の動きに応じて動作し、現実の模型では見ることができない地下空間や内部空間を可視化します。また、実際の体験者以外にも、VRブースからAR都市ミュージアムに参加することができ、アバターを介してリアルタイムに体験者とコミュニケーションすることができます。VRとAR技術を応用することで、現実空間と仮想空間をリンクすることで、将来的には時と場所を越えて人があつまり、現実と仮想、相互に事業の活性化を促進できるモデルを構築します。

インドのトランスメディアコンテンツの動向

ボストンメディアテック株式会社

最新のインドのトランスメディアコンテンツ動向とボストンメディアテックの高度な技術力を実際の映像でご覧頂きます。

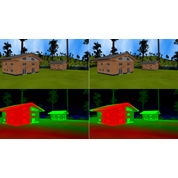

人に優しい高臨場感映像コンテンツの生成技術

凸版印刷株式会社

立体映像や大画面インタラクティブ映像などの高臨場感映像コンテンツでは、構図、カメラの動き、視差、などの映像の特徴によってその印象や効果が大きく変化します。

特に、不適切な条件を設定すると、期待する効果が得られないだけでなく、映像酔いや視覚疲労などの好ましくない影響を視聴者に与える場合もあります。

これらの効果を予め評価あるいは予測することができれば、映像コンテンツの表現品質を大きく向上させることができます。

この展示では、様々に条件を変えた映像をリアルタイムで生成できるリアルタイムCG技術を用いて、立体映像コンテンツの立体感の制御、体験型インタラクティブ映像でのカメラワークの制御など、効果の高い高臨場感映像を生成するための取り組みやその効果について紹介します。

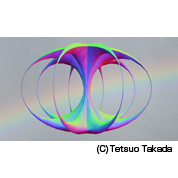

3D立体アートの研究

文教大学 情報学部

造形芸術では最初に自然の形から学びます。CG技術を駆使した表現においてもそのステップは同じです。しかし、決定的に違うのは再構築のステップです。そして手描きでイメージする以上にダイナミックな発想で構成することができます。”題材”、”構成”、”空間造形”、”材質感”、”照明”、”リアリティ”、”ストーリー”、”アクション”、”仕掛け”、等の諸条件を変更することでどのように表現が変化するかを瞬時比較評価することができます。

日曜劇場「南極大陸」のVFX

株式会社TBSテレビ

TBSの日曜劇場「南極大陸」では、南極の氷や風景、ブリザード、そして昭和30年代の町並みまで、あらゆるシチュエーションを全10話、高度なCG技術を使い、壮大なスケールのVFXで描き上げました。CGとは感じさせないリアルで説得力あるVFX映像で、ドラマ全体の世界観を支えています。中でも、南極観測船「宗谷」は、実写を全く使わずに、全てCGでゼロから作り出したデジタル映像です。特に宗谷が氷を砕いて突き進む映像などは、実際に撮影できないがゆえ全てをCGで作り上げる必要があり、なおかつ、これまでの国内の技術では到達することの出来なかった高いリアリティーで、写実的に描き上げたフル・デジタル映像です。本作の中でも最も高度な技術を駆使しています。他にも、ドッグで建造される宗谷など、その姿をリアルに再現しています。

バーチャルヒューマノイド

横浜国立大学 成長戦略研究センター 庄司道彦

バーチャルヒューマノイドは、拡張現実(AR)技術を用いて、ロボットに映像を合成するシステムです。このシステムはヘッドマウントディスプレイ(HMD)、ロボット、ロボットに合成されるCGキャラクターの3要素で構成され、空想のキャラクターにも手を触れることを可能にします。HMDを装着すると、ロボットを塗りつぶすようにCGキャラクターが表示されます。HMDにはカメラが内蔵されており、このカメラで撮った画像はPCに転送された後で合成映像に加工され、ほぼリアルタイムでHMDの接眼面のディスプレイに転送されます。このようにしてARによる変身ロボットを実現しているのです。なお、本研究は独立行政法人科学技術振興機構(JST) 若手研究者ベンチャー創出推進事業に採択された研究課題「ロボットへの仮想キャラクタ映像合成システムの開発」(研究代表者:庄司道彦、研究期間:2009年度~2011年度)として行われたものです。

SHelective

東京大学大学院情報理工学系研究科 苗村研究室(伏木秀樹,苗村健)

一つの画面を多人数で共有しようとした場合に、その中には見られたくない情報も含まれ、共有に支障を来たす可能性があります。それを回避するため、共有する情報と共有しない情報を切り分け共有する情報のみを表示するというシステムです。上記の具体例としてPCなどに外部ディスプレイを接続してそれを他者と共有して作業を行う場面が想定できます。その際、自身の画面をそのまま「複製」して表示するか、描画領域を「拡張」して自身の画面とは別の内容を表示するのが一般的です。このように外部ディスプレイを他者と共有して協調作業を行う場合、「複製」では意図せず個人的な情報が表示されてしまい「拡張」では外部ディスプレイ上での操作が煩雑になるという問題があります。これら既存の手法の抱える問題を解決するために複製・拡張に代わる第3 の手法として,新たにアプリケーションウィンドウ単位での「選択的複製」による情報共有手法を提案・実装しまし。このシステムは、「選択的に情報を複製して共有する」ためSHaring information by selective mirroringから「SHelective」と呼びます。

ラジへぇ

東京大学大学院学際情報学府 苗村研究室(加藤由訓、苗村健)

ラジオ放送は、近年インターネット配信が開始されSNSとの連携が進むなど、新しいメディアとして生まれ変わりつつあります。「ラジへぇ」はラジオ番組聴取時に、遠く離れたリスナー同士で声の効果音を鳴らし合い感想を共有するシステムです。笑い声・「うん」・「へぇ」・「いいね」・「えー」・「マジで」などの声の効果音を用いています。参加者は、ウェブページ上のボタンを押す事で効果音を鳴らし、また、他のリスナーの鳴らした効果音を聴くことで、感想を共有します。文字ではなく音を用いて感想を共有することで、別の作業をしながらなど、画面を目で追えない「ながら聴き」中でも利用できます。本展示では、2012年8月~9月にかけて行った「くらもといたるのいたらナイト」(京都三条ラジオカフェ)での「ラジへぇ」実証実験の様子について紹介します。実証実験では、番組内容に連携した感想が入力され、リスナーの間に一体感をもたらすような感想共有が行われていることが確認できました。

MRsionCase

東京大学 情報理工学系研究科 苗村研究室(金ハンヨウル,長尾俊,苗村健) / 独立行政法人情報通信研究機構(前川聡)

ハーフミラーを展示物の前後に斜めに配置し、ディスプレイの映像を反射させることによって展示物の前後に関連情報の映像を浮かばせることができます。また、ハーフミラーの代わりに、反射像が前に飛び出す実像鏡を用いることによって展示物上の任意の位置に映像を浮かばせることができました。これによって関連情報が展示物と空間的な整合性をもって提示できるので、より直感的に展示物への理解を深めることができます。MRsionCaseではこれを組み合わせることによって4方向で空中像がデバイス無しで見えるような展示ショーケースにしました。

更に、音が一方向だけに届く超指向性スピーカを用いてハーフミラーに音を反射させることで、視界にスピーカが入らずに音声が展示物から聞こえてくるようにしました。音は指向性をもつため、4方向で別々の音声情報をデバイス無しで聞くことができます。また、超指向性スピーカの反射角度を変えることで、同じ方向でも大人と子供のように身長の違う人に違う音声情報を提供することができます。

デジタルツールを活用したトランスポーテーションデザイン開発

首都大学東京 インダストリアルデザインコース トランスポーテーションデザインスタジオ

トランスポーテーションのデザイン手法において、技術先行の構築もありますが、より感性に訴えるデザインが求められる現代においては、技術でさえ、感性を表現するデザインの一つと考えられます。そこで我々はデジタルを使ったデザインツールを活用することにより「共感」を深めながら「モノ」づくりを進めるデザインが可能になると考えています。デザインにおいてアイデアは、「かたち」であったり、「言葉」であったり、「イメージ」であったりさまざまなメディアであると言えます。たとえば今までのデザイン手法では「デッサン」や「スケッチ」などの「絵」的な表現を中心としてデザインが進められてきましたが、様々なメディア(立体や写真、色や素材、仕上げまでも)を総合的な表現の可能性を活用したデザイン開発が可能になると考えられます。本展示ではこのようなデザインプロセスを体験も交えながら展開します。

プロジェクターで作り出す不思議な世界

NECディスプレイソリューションズ株式会社/神奈川工科大学/日本電子専門学校

「プロジェクターで作り出す不思議な世界」プロジェクターの使い方は映画やプレゼンテーションだけではありません!この展示では、プロジェクターを使って、未来的な不思議な体験を作り出しています。

未来KADENプロジェクト2012

首都大学東京 システムデザイン研究科

KADEN projectはシステムデザイン学部/学域のヒューマンメカトロニクスシステムとインダストリアルアートの教員が協力して学部3年次から大学院修士1年次までの両所属の学生を対象とし、両者の専門領域を生かした協働作業をPBL形式で行い新しい家電(アプライアンス)を設計・デザインし、プロトタイプ製作、成果発表を実施することによりイノベーティブな知的生産物を創造するスキルを身につけることを目標とした教育プロジェクトになります。イノベーションデザインの視点での発想法を軸にしながら、学内にある研究シーズや技術を活用しデザイナーとエンジニアが協働創造し、実働するプロトタイプを制作し、新しい「KADEN」製品の提案をおこないます。

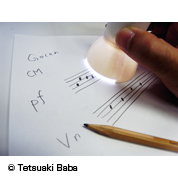

Gocen:手書き譜面演奏システム

首都大学東京 IDEEA Lab. (串山・馬場 研究室)

本システムは主にスキャンデバイス、コンピュータ、音源の3つからなります。ユーザはデバイスを手に持ち、スキャン操作を行うことで、手書きされた音符を演奏することができます。テバイスから入力されたカメラ画像はOpenCVライブラリと独自アルゴリズムによって解析され、記述された音程を認識します。記述するペンや紙には特別なものでなく、一般的なボールペンやコピー用紙を利用することができます。スキャンデバイスは図2に示すように、CMOSカメラ、操作用スイッチ、振動モータ、マイクロコンピュータから構成されています。

高画質を追求した4K対応テレビ[84V型](参考出品)

株式会社 東芝

世界初(* 1)の4K対応テレビを昨年市場投入した当社は、更に高画質を追求した第二世代機を開発。今回の84V型4K対応テレビは、独自開発の“レグザエンジンCEVO 4K”を搭載。画素数は通常のフルHDTVの4倍。高精細で深みのある映像を提供。ブルーレイ(* 2) などのハイビジョン映画を、最新の超解像処理や復元技術を有した“レグザエンジンCEVO 4K”で高精細に再現し、ご家庭のリビングで最新の映画館のような感動を体験できます。

*1民生用デジタルハイビジョン液晶テレビにおいて。東芝調べ。 *2 Blu-rayはブルーレイディスク・アソシエーションの商標です。

インドネシアのデジタル・クリエイティブ産業

インドネシア共和国観光クリエイティブエコノミー省

インドネシアのデジタルコンテンツ産業は何百ものゲーム開発企業、ソフトウェア開発企業、アニメーション制作スタジオ等で構成されており、クリエイティビティが最大の強みです。 2億を超えるモバイルユーザーと5,000万を超えるインターネットユーザーを擁するインドネシアのデジタルコンテンツ産業は急速に発展しています。 Kuassa社は、ギターアンプとオーディオ・プロセシングを専門とする企業です。Kuassaはギター・アンプ・シミュレーター「Amplifikation One」を開発。複雑なパラメータや作業無しで、即座に現実に近いギターの音を紡ぎ出し、素晴らしい曲を作ることが出来ます。

今回は、先着100名様に最新ギターアンプソフト「Amplifikation Vermilion」のライセンスを無料配布します。

是非ブースにお立ち寄りください!

http://www.kuassa.com/posts/japan-get-ready-we-will-launch-amplifikation-vermilion-at-dcexpo-2012-tokyo.html

HTML5を、遊ぼう!使おう!語っちゃおう!

株式会社アスキー・メディアワークス 角川アスキー総合研究所

シンボルゾーンでは「日本最強!HTML5プログラマーバトル」と題

し、角川アスキー総合研究所遠藤ゼネラルマネージャーと、ユビキ

タスエンターテインメント清水代表取締役社長兼CEOによるステー

ジイベントを開催します。ゲストとのトークショーをはじめ、僅か

9分間で「enchant.js」を使った即興ゲームプログラミングを競う

「9 minutes battle」や「前田ブロック」による初学者向けワーク

ショップを展開します。

※詳しいスケジュールは こちらをご覧ください。